高帯域幅メモリ市場 規模・シェア分析 – 成長トレンドと予測 (2025-2030年)

高帯域幅メモリ(HBM)市場は、アプリケーション(サーバー、ネットワーキング、ハイパフォーマンスコンピューティング、家電製品など)、テクノロジー(HBM2、HBM2E、HBM3、HBM3E、HBM4)、スタックあたりのメモリ容量(4GB、8GB、16GB、24GB、32GB以上)、プロセッサインターフェース(GPU、CPU、AIアクセラレーター/ASIC、FPGAなど)、および地域(北米、南米、ヨーロッパ、アジア太平洋、中東およびアフリカ)によってセグメント化されています。

※本ページの内容は、英文レポートの概要および目次を日本語に自動翻訳したものです。最終レポートの内容と異なる場合があります。英文レポートの詳細および購入方法につきましては、お問い合わせください。

*** 本調査レポートに関するお問い合わせ ***

高帯域幅メモリ(HBM)市場の概要:成長トレンドと予測(2025年~2030年)

導入部

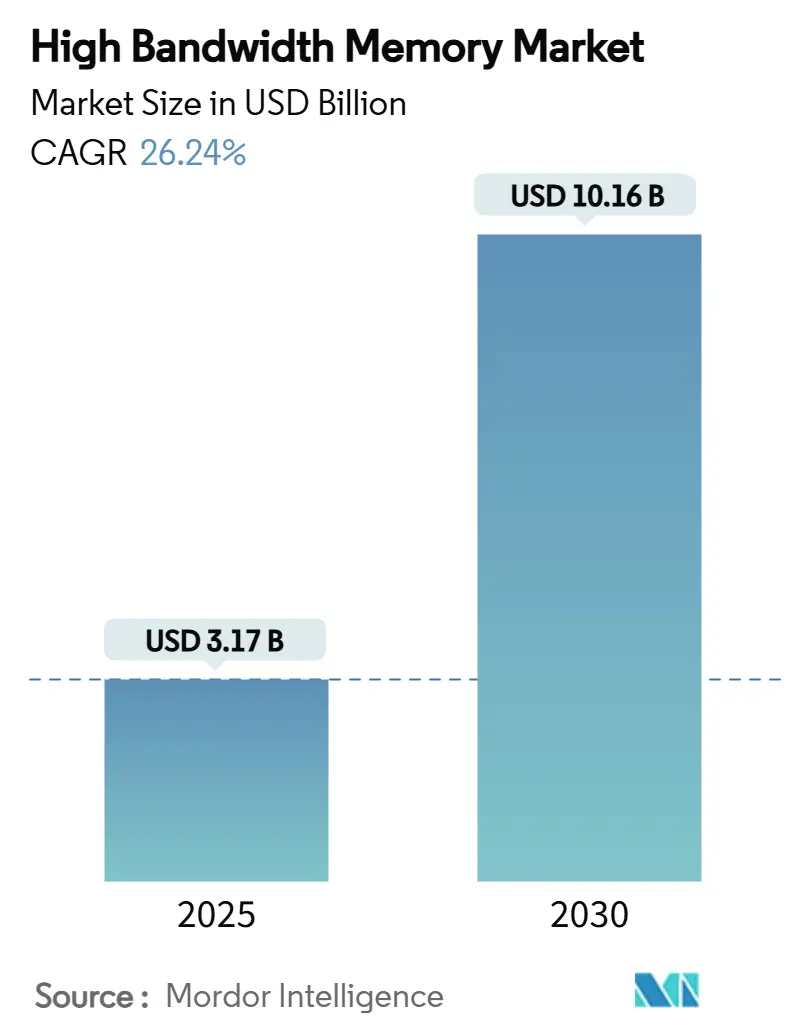

高帯域幅メモリ(HBM)市場は、2025年には31.7億米ドル規模に達し、2030年には101.6億米ドルに成長すると予測されており、予測期間中の年平均成長率(CAGR)は26.24%と見込まれています。この成長は、AI最適化サーバーへの持続的な需要、DDR5の広範な採用、ハイパースケーラーによる積極的な設備投資によって牽引されています。過去1年間で、サプライヤーはTSV(Through-Silicon Via)の歩留まり改善に注力し、パッケージングパートナーは基板不足を緩和するためにCoWoS(Chip-on-Wafer-on-Substrate)ラインへの投資を強化しました。自動車メーカーは、レベル3およびレベル4の自動運転プラットフォーム向けにISO 26262認定のHBMを確保するため、メモリベンダーとの連携を深めています。アジア太平洋地域の製造エコシステムは、韓国メーカーが次世代HBM4Eの生産拡大に数十億ドル規模の投資をコミットしたことで、引き続き生産を主導しています。

主要な市場動向と洞察

市場を牽引する要因:

1. AIサーバーの普及とGPU搭載率の向上: 大規模言語モデルの急速な成長により、2024年には従来のHPCデバイスと比較して、GPUあたりのHBM要件が7倍に増加しました。NVIDIAのH100は80GBのHBM3を搭載し3.35 TB/sの帯域幅を提供し、2025年初頭にサンプル出荷されたH200は141GBのHBM3Eを搭載し4.8 TB/sを実現しています。この需要により、サプライヤーの生産能力は2026年までほぼ埋まっており、データセンター事業者は在庫の事前購入やパッケージングラインへの共同投資を余儀なくされています。

2. データセンターにおけるDDR5および2.5Dパッケージングへの移行: ハイパースケーラーは、ワットあたりの性能が50%向上するDDR5へのワークロード移行を進めるとともに、AIアクセラレーターと積層メモリをシリコンインターポーザー上で接続する2.5D統合を採用しています。単一のパッケージングプラットフォームへの依存は、2024年を通じて基板不足がGPUの発売を遅らせた際にサプライチェーンのリスクを高めました。

3. 車載ADASにおけるエッジAI推論: レベル4の自動運転車は1 TB/sを超えるセンサーデータを処理するため、自動車業界はISO 26262認定のHBM4サンプルへと移行しています。メモリベンダーは、機能安全要件を満たすために、内蔵ECCや強化された熱監視機能を含む安全指向の設計を導入しています。

4. ハイパースケーラーによるシリコンインターポーザースタックの選好: AWS、Google、MicrosoftなどのカスタムAIチップは、TSMCのCoWoSを通じて複数のHBMスタックを統合し、10,000接続/mm²を超える相互接続密度を達成しています。ベンダーは、生産能力不足に対応するため、専用のインターポーザーラインに資金を投入し、インターポーザーのフットプリントを縮小するチップレットアーキテクチャを共同開発しています。

5. メモリ生産に対する地域的な補助金: 米国、韓国、日本などで、メモリ生産を促進するための補助金が提供されています。

6. フォトニクス対応HBMロードマップ: 研究センターでの早期採用が見られます。

市場の抑制要因:

1. 12層を超えるスタックにおけるTSVの歩留まり損失: 16層のHBMスタックでは、熱サイクルがTSV内の銅マイグレーション故障を引き起こし、歩留まりが70%を下回りました。メーカーは信頼性を安定させるために、熱貫通シリコンビア設計や新しい誘電体材料を追求していますが、商業化にはまだ2年を要すると見られています。

2. CoWoS/SoICの高度パッケージング能力の制限: 2024年にはCoWoSラインの稼働率が平均95%に達し、基板メーカーは十分な量のT-Glassを供給するのに苦慮しました。これにより、上位顧客への割り当てが行われ、新たなAIアクセラレータープログラムが遅延しました。SamsungのSoICやIntelのEMIBといった代替フローは早期生産段階に入っていますが、短期的な不足を補うには至っていません。

3. 1 TB/sを超える帯域幅デバイスにおける熱スロットリング: データセンターを中心に、高帯域幅デバイスにおける熱問題が課題となっています。

4. AIアクセラレーターに対する地政学的な輸出規制: 中国への輸出規制が世界的な波及効果をもたらしています。

セグメント分析

1. アプリケーション別:サーバーがインフラ変革を牽引

* サーバー: 2024年にはHBM市場の収益シェアの68.5%を占め、ハイパースケールオペレーターがAIサーバーへの移行を進めていることを反映しています。各AIサーバーは8〜12個のHBMスタックを統合し、クラウドプロバイダーがGPUあたり3 TB/sを超える帯域幅に依存する基盤モデルサービスを開始したことで需要が加速しました。2025年のエネルギー効率目標は、ディスクリートソリューションよりも優れたワットあたりの性能を提供する積層DRAMを支持し、データセンター事業者が電力制限内で運用することを可能にしています。企業のリフレッシュサイクルも始まり、DDR4ベースのノードがHBM対応アクセラレーターに置き換えられ、2027年まで購入コミットメントが延長されています。

* 自動車および輸送: 現在はより小規模なセグメントですが、2030年までに35.6%のCAGRで最も速い成長を遂げると予測されています。チップメーカーはティア1サプライヤーと協力し、ASIL D要件を満たす機能安全機能を組み込んでいます。ヨーロッパと北米では、2024年後半にレベル3生産プログラムが限定的に開始され、各車両が以前はデータセンター推論クラスター向けだったメモリ帯域幅を使用しています。OTA(Over-The-Air)アップデート戦略が成熟するにつれて、自動車メーカーは自動車をエッジサーバーとして扱い始め、HBMの搭載率をさらに維持しています。

2. テクノロジー別:HBM3の優位性にHBM3Eが挑戦

* HBM3: 2024年にはAIトレーニングGPUで広く採用され、収益の46.3%を占めました。

* HBM3E: 2024年第1四半期にサンプル出荷が開始され、初期生産では9.2 Gb/sを超えるピン速度で稼働しました。性能向上によりスタックあたり1.2 TB/sに達し、目標帯域幅に必要なスタック数を減らし、パッケージの熱密度の管理がより重要になります。

このレポートは、高帯域幅メモリ(HBM)市場に関する包括的な分析を提供しています。HBMは、3Dスタック型同期ダイナミックランダムアクセスメモリ(SDRAM)向けの高速コンピュータメモリインターフェースであり、高性能ネットワークハードウェア、データセンターのAI ASIC、FPGA、スーパーコンピュータといった先進的なシステムで不可欠な役割を果たしています。本レポートでは、市場の定義、調査範囲、調査方法、エグゼクティブサマリー、市場の状況、市場規模と成長予測、競争環境、市場機会と将来展望といった多岐にわたる側面を網羅しています。

市場規模と成長予測:

HBM市場は、AI技術の急速な進化とデータ処理需要の増大を背景に、顕著な成長を遂げると予測されています。具体的には、2025年には31.7億米ドルの市場規模に達し、2030年までには101.6億米ドルへと拡大すると見込まれています。

市場の推進要因:

市場の成長を牽引する主要な要因としては、AIサーバーの普及とGPU搭載率の増加が挙げられます。また、データセンターにおけるDDR5および2.5Dパッケージングへの移行、自動車の先進運転支援システム(ADAS)におけるエッジAI推論の需要拡大、ハイパースケーラーによるシリコンインターポーザースタックの選好も重要な推進力です。さらに、韓国、米国、日本といった主要国におけるメモリの現地生産を促進する補助金政策や、将来を見据えたフォトニクス対応HBMロードマップ(HBM-P)の開発も市場の活性化に寄与しています。

市場の阻害要因:

一方で、市場にはいくつかの課題も存在します。12層を超えるスタックにおけるTSV(Through-Silicon Via)の歩留まり損失は、製造コストと効率に影響を与えています。また、CoWoS/SoICなどの先進パッケージング技術の容量が限られていること、1TB/sを超える帯域幅を持つデバイスにおける熱スロットリングの問題、そしてAIアクセラレータに対する地政学的な輸出規制も市場の成長を抑制する要因となっています。

主要な市場動向と洞察:

* アプリケーション別: サーバーセグメントがHBM市場を強力に牽引しており、2024年の収益の68.5%を占めました。これは、ハイパースケーラーがAI中心のアーキテクチャを積極的に採用していることに起因しています。

* テクノロジー別: HBM3Eは、スタックあたり最大1.2 TB/sという高い帯域幅と優れた電力効率を提供するため、次世代GPUおよびAIアクセラレータの主要な選択肢として市場シェアを急速に拡大しています。

* 自動車分野での採用: 自動車メーカーは、レベル3およびレベル4の自動運転システムが要求する膨大なメモリ帯域幅に対応するため、ISO 26262認定のHBM4への移行を進めています。

* 地域別: アジア太平洋地域は、HBMの製造および先進パッケージング能力の大部分を擁しており、収益シェアの41%以上を占める最大の市場となっています。

詳細な市場分析:

本レポートでは、市場の状況を多角的に分析しています。これには、バリューチェーン分析、規制環境、技術的展望、ポーターのファイブフォース分析(サプライヤーとバイヤーの交渉力、新規参入の脅威、代替品の脅威、競争の激しさ)、DRAM市場分析(収益と需要予測、地域別収益、DDR5製品の現在の価格、DDR5製品メーカーリスト)、およびマクロ経済要因の影響などが含まれます。

市場セグメンテーション:

HBM市場は、以下の詳細なセグメントに分類され、分析されています。

* アプリケーション別: サーバー、ネットワーキング、高性能コンピューティング、家電、自動車・輸送。

* テクノロジー別: HBM2、HBM2E、HBM3、HBM3E、HBM4。

* スタックあたりのメモリ容量別: 4 GB、8 GB、16 GB、24 GB、32 GB以上。

* プロセッサインターフェース別: GPU、CPU、AIアクセラレータ/ASIC、FPGA、その他。

* 地域別: 北米(米国、カナダ、メキシコ)、南米(ブラジル、その他)、欧州(ドイツ、フランス、英国、その他)、アジア太平洋(中国、日本、インド、韓国、その他)、中東・アフリカ(中東、アフリカ)。

競争環境:

競争環境の分析では、市場の集中度、主要企業の戦略的動向、市場シェアの詳細な分析が行われています。Samsung Electronics Co., Ltd.、SK hynix Inc.、Micron Technology, Inc.、Intel Corporation、Advanced Micro Devices, Inc.、Nvidia Corporation、Taiwan Semiconductor Manufacturing Company Limited (TSMC) など、グローバルレベルで事業を展開する25社以上の主要企業のプロファイルが提供されており、各社の概要、主要セグメント、財務情報、戦略、市場ランク/シェア、製品とサービス、最近の動向などが詳述されています。

市場機会と将来展望:

レポートの最終章では、未開拓の市場領域(ホワイトスペース)や満たされていないニーズの評価を通じて、HBM市場における新たな機会と将来の展望が提示されています。

このレポートは、HBM市場の現状と将来の方向性を理解し、ビジネス戦略を策定するための貴重な情報源となるでしょう。

1. はじめに

- 1.1 調査の前提と市場の定義

- 1.2 調査の範囲

2. 調査方法

3. エグゼクティブサマリー

4. 市場概況

- 4.1 市場概要

-

4.2 市場の推進要因

- 4.2.1 AIサーバーの普及とGPU搭載率

- 4.2.2 データセンターのDDR5および2.5Dパッケージングへの移行

- 4.2.3 車載ADASにおけるエッジAI推論

- 4.2.4 ハイパースケーラーによるシリコンインターポーザースタックの選好

- 4.2.5 地域ごとのメモリ生産補助金(韓国、米国、日本)

- 4.2.6 フォトニクス対応HBMロードマップ(HBM-P)

-

4.3 市場の阻害要因

- 4.3.1 12層以上のスタックにおけるTSV歩留まり損失

- 4.3.2 CoWoS/SoICの高度パッケージング能力の制限

- 4.3.3 1 TB/sを超える帯域幅デバイスにおける熱スロットリング

- 4.3.4 AIアクセラレーターに対する地政学的輸出規制

- 4.4 バリューチェーン分析

- 4.5 規制環境

- 4.6 技術的展望

-

4.7 ポーターの5つの力分析

- 4.7.1 供給者の交渉力

- 4.7.2 買い手の交渉力

- 4.7.3 新規参入の脅威

- 4.7.4 代替品の脅威

- 4.7.5 競争の激しさ

-

4.8 DRAM市場分析

- 4.8.1 DRAMの収益と需要予測

- 4.8.2 地域別DRAM収益

- 4.8.3 DDR5製品の現在の価格設定

- 4.8.4 DDR5製品メーカーリスト

- 4.9 マクロ経済要因の影響

5. 市場規模と成長予測(金額)

-

5.1 アプリケーション別

- 5.1.1 サーバー

- 5.1.2 ネットワーキング

- 5.1.3 ハイパフォーマンスコンピューティング

- 5.1.4 家庭用電化製品

- 5.1.5 自動車および輸送

-

5.2 テクノロジー別

- 5.2.1 HBM2

- 5.2.2 HBM2E

- 5.2.3 HBM3

- 5.2.4 HBM3E

- 5.2.5 HBM4

-

5.3 スタックあたりのメモリ容量別

- 5.3.1 4 GB

- 5.3.2 8 GB

- 5.3.3 16 GB

- 5.3.4 24 GB

- 5.3.5 32 GB以上

-

5.4 プロセッサーインターフェース別

- 5.4.1 GPU

- 5.4.2 CPU

- 5.4.3 AIアクセラレーター / ASIC

- 5.4.4 FPGA

- 5.4.5 その他

-

5.5 地域別

- 5.5.1 北米

- 5.5.1.1 米国

- 5.5.1.2 カナダ

- 5.5.1.3 メキシコ

- 5.5.2 南米

- 5.5.2.1 ブラジル

- 5.5.2.2 その他の南米

- 5.5.3 ヨーロッパ

- 5.5.3.1 ドイツ

- 5.5.3.2 フランス

- 5.5.3.3 イギリス

- 5.5.3.4 その他のヨーロッパ

- 5.5.4 アジア太平洋

- 5.5.4.1 中国

- 5.5.4.2 日本

- 5.5.4.3 インド

- 5.5.4.4 韓国

- 5.5.4.5 その他のアジア太平洋

- 5.5.5 中東およびアフリカ

- 5.5.5.1 中東

- 5.5.5.1.1 サウジアラビア

- 5.5.5.1.2 アラブ首長国連邦

- 5.5.5.1.3 トルコ

- 5.5.5.1.4 その他の中東

- 5.5.5.2 アフリカ

- 5.5.5.2.1 南アフリカ

- 5.5.5.2.2 その他のアフリカ

6. 競争環境

- 6.1 市場集中度

- 6.2 戦略的動き

- 6.3 市場シェア分析

-

6.4 企業プロファイル(グローバルレベルの概要、市場レベルの概要、主要セグメント、財務、戦略情報、市場ランク/シェア、製品とサービス、最近の動向を含む)

- 6.4.1 サムスン電子株式会社

- 6.4.2 SKハイニックス株式会社

- 6.4.3 マイクロン・テクノロジー株式会社

- 6.4.4 インテル株式会社

- 6.4.5 アドバンスト・マイクロ・デバイセズ株式会社

- 6.4.6 エヌビディア株式会社

- 6.4.7 台湾積体電路製造株式会社

- 6.4.8 ASEテクノロジー・ホールディング株式会社

- 6.4.9 アンコール・テクノロジー株式会社

- 6.4.10 パワーテック・テクノロジー株式会社

- 6.4.11 ユナイテッド・マイクロエレクトロニクス株式会社

- 6.4.12 グローバルファウンドリーズ株式会社

- 6.4.13 アプライド・マテリアルズ株式会社

- 6.4.14 マーベル・テクノロジー株式会社

- 6.4.15 ランバス株式会社

- 6.4.16 ケイデンス・デザイン・システムズ株式会社

- 6.4.17 シノプシス株式会社

- 6.4.18 シリコンウェア・プレシジョン・インダストリーズ株式会社

- 6.4.19 JCETグループ株式会社

- 6.4.20 チップボンド・テクノロジー株式会社

- 6.4.21 ケイデンス・デザイン・システムズ株式会社

- 6.4.22 ブロードコム株式会社

- 6.4.23 セレスティアルAI

- 6.4.24 ASE-SPIL(シリコン製品)

- 6.4.25 グラフコア・リミテッド

7. 市場機会と将来展望

*** 本調査レポートに関するお問い合わせ ***

高帯域幅メモリ、通称HBM(High Bandwidth Memory)は、現代の高性能コンピューティングにおいて不可欠な技術であり、特に人工知能、ハイパフォーマンスコンピューティング、データセンターなどの分野でその重要性が増しています。これは、複数のDRAMダイを垂直に積層し、シリコンインターポーザーを介してホストチップ(GPUやCPUなど)と接続することで、従来のメモリと比較して圧倒的な帯域幅、優れた電力効率、そして省スペースを実現する革新的なメモリ技術でございます。

HBMの最大の特徴は、その「高帯域幅」にあります。従来のDDRやGDDRメモリが、少数のデータピンを高クロックで動作させるのに対し、HBMは非常に多数のデータピン(例えば、1024ビット幅)を比較的低クロックで並列に動作させることで、桁違いのデータ転送能力を実現します。この広帯域幅は、大量のデータを高速に処理する必要があるアプリケーションにとって極めて有利であり、特にAIモデルのトレーニングや推論、科学技術計算、グラフィックスレンダリングといった分野でその真価を発揮いたします。また、メモリとホストチップ間の物理的な距離が短いため、信号伝送の遅延が少なく、消費電力も抑えられるという利点もございます。

HBMにはいくつかの世代が存在し、それぞれ性能と機能が向上しております。最初のHBM1は、JEDECによって標準化され、2013年に発表されました。その後、2016年にはHBM2が登場し、HBM1と比較して帯域幅と容量が大幅に向上し、より広範な採用が進みました。HBM2EはHBM2の拡張版として、さらに高いデータ転送速度とスタックあたりの容量を実現しております。そして、最新のHBM3は、HBM2Eからさらに帯域幅と容量を倍増させ、電力効率も改善されております。HBM3は、独立したチャネル操作やエラー訂正機能の強化など、より高度な機能も提供し、次世代のAIアクセラレータやスーパーコンピュータの性能を支える基盤となっております。さらに、HBM3EやHBM3 Gen2といったさらなる高速化・大容量化を目指す派生バージョンも開発が進められており、技術の進化は止まることがございません。

HBMの主な用途は、前述の通り、極めて高いメモリ帯域幅を要求する分野に集中しております。最も代表的なのは、NVIDIAのGPUやAMDのInstinctシリーズといったAIアクセラレータやハイエンドGPUです。これらのチップは、ディープラーニングのトレーニングや推論において、膨大な量のデータを並列に処理する必要があり、HBMの広帯域幅がボトルネックの解消に貢献しております。また、スーパーコンピュータや高性能ワークステーション、データセンター向けのサーバー、さらには高性能ネットワーク機器などでも採用が進んでおります。これらのシステムでは、リアルタイムでの大規模データ処理や複雑なシミュレーションが求められるため、HBMの高速性と効率性が不可欠でございます。

HBMの実現には、いくつかの関連技術が密接に関わっております。その中核をなすのが「TSV(Through-Silicon Via:シリコン貫通ビア)」技術です。これは、複数のDRAMダイを垂直に積層し、各ダイを電気的に接続するための微細な穴をシリコンウェハに開け、そこに導電性材料を充填する技術でございます。これにより、従来のワイヤーボンディングに比べて、はるかに短く、多数の接続が可能となり、高帯域幅と低消費電力を実現しております。また、「シリコンインターポーザー」も重要な役割を担います。これは、HBMスタックとホストチップ(GPUなど)を物理的・電気的に接続するための中間層であり、非常に高密度な配線パターンを持つことで、両者間の高速なデータ転送を可能にしております。TSMCのCoWoS(Chip-on-Wafer-on-Substrate)のような先進的なパッケージング技術は、これらのHBMとホストチップを統合するための代表的なソリューションでございます。

市場背景としましては、近年、人工知能(AI)技術の急速な発展と普及が、HBM市場を牽引する最大の要因となっております。特に、大規模言語モデル(LLM)の登場により、AIモデルの規模と複雑性が増大し、それに伴い、AIアクセラレータに対するメモリ帯域幅の要求が爆発的に高まっております。この需要に応える形で、SK Hynix、Samsung、Micronといった主要なメモリメーカーがHBMの生産を強化しており、NVIDIA、AMD、Intelといった半導体メーカーが自社の高性能チップにHBMを積極的に採用しております。HBMは製造プロセスが複雑でコストも高いため、供給能力が限られており、需要の急増に対して供給が追いつかない状況が続いております。このため、HBMは半導体市場において戦略的に重要なコンポーネントとなっており、その安定供給が各社の競争力に直結する状況でございます。

将来展望としましては、HBM技術は今後も進化を続け、その重要性はさらに高まることが予想されます。AIの進化は止まることがなく、より大規模で複雑なモデルが登場するにつれて、HBMに対する帯域幅と容量の要求はさらに増大するでしょう。HBM4やそれ以降の世代では、さらなる高速化、大容量化、そして電力効率の向上が図られると見込まれております。また、現在の2.5Dパッケージングから、より高度な3D統合技術への移行も検討されており、将来的にはHBMがロジックチップと直接積層されるような、真の3Dスタッキングが実現する可能性もございます。これにより、メモリとプロセッサ間のデータ転送効率がさらに向上し、システム全体の性能が飛躍的に向上することが期待されます。コスト削減と生産効率の向上も重要な課題であり、より広範なアプリケーションへのHBMの採用を促進するためには、これらの課題を克服する必要がございます。HBMは、次世代のコンピューティングを支える基盤技術として、今後もその進化と応用範囲を拡大していくことでしょう。