説明可能なAI市場:規模・シェア分析、成長動向と予測 (2025-2030年)

説明可能なAI市場レポートは、提供形態(ソリューションとサービス)、展開形態(クラウドとオンプレミス)、エンドユーザー産業(BFSI、ヘルスケア、製造業、小売業、IT・通信など)、および地域によってセグメント化されています。市場予測は、金額(米ドル)で提供されます。

※本ページの内容は、英文レポートの概要および目次を日本語に自動翻訳したものです。最終レポートの内容と異なる場合があります。英文レポートの詳細および購入方法につきましては、お問い合わせください。

*** 本調査レポートに関するお問い合わせ ***

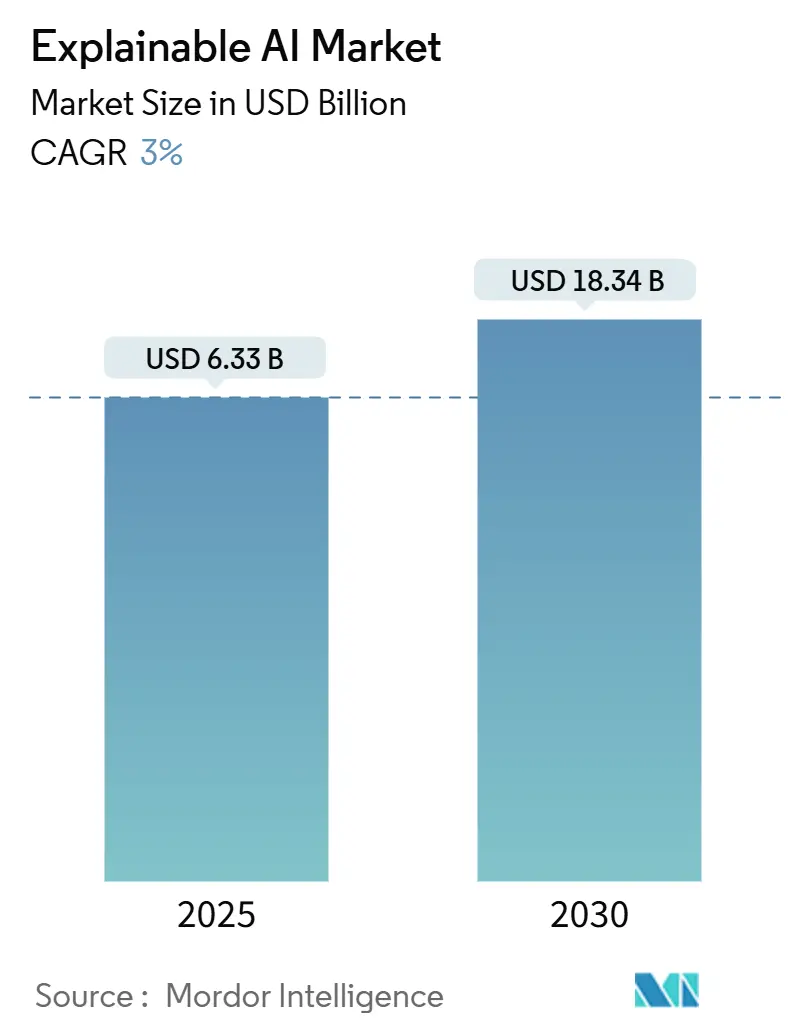

Explainable AI(XAI)市場は、2025年から2030年の予測期間において、大幅な成長が見込まれています。Mordor Intelligenceの分析によると、市場規模は2025年の63.3億米ドルから、2030年には183.4億米ドルに達すると予測されており、予測期間中の年平均成長率(CAGR)は3%です。この成長は、リスクベースの規制、クラウドファーストの導入経済性、および高リスク分野におけるモデルリスクに対する経営層の監視強化によって支えられています。EU AI法、米国のモデルリスクガイダンス、およびアジア太平洋地域の規制調和により、透明性はオプション機能から事業運営の必須要件へと格上げされました。継続的なデータ中心の開発、クラウドGPU容量の拡大、および統合されたAIガバナンススイートが、XAI市場全体での採用をさらに加速させています。モデルの可観測性、バイアス軽減、監査対応レポート作成を組み合わせることができるベンダーは、企業がポイントツールをエンドツーエンドのプラットフォームに置き換えるにつれて、最大の機会を獲得する立場にあります。

本レポートでは、XAI市場をオファリング(ソリューションおよびサービス)、展開形態(クラウドおよびオンプレミス)、エンドユーザー産業(BFSI、ヘルスケア、製造、小売、IT・通信など)、および地域別に分析しています。

主要なレポートのポイント

* オファリング別: 2024年にはソリューションがXAI市場シェアの74%を占め、サービスは2030年までに35.4%のCAGRで成長すると予測されています。

* 展開形態別: 2024年にはクラウドがXAI市場規模の67%の収益シェアを獲得し、2025年から2030年の間に33.6%のCAGRで拡大する見込みです。

* エンドユーザー産業別: 2024年にはBFSIがXAI市場規模の29%を占めましたが、ヘルスケア分野は2030年までに42.1%のCAGRで急成長すると予測されています。

* 地域別: 2024年には北米がXAI市場規模の43%を占めましたが、アジア太平洋地域は2030年までに31.8%のCAGRで急成長すると予測されています。

グローバルExplainable AI市場のトレンドと洞察

市場の牽引要因

XAI市場の成長を牽引する主な要因は以下の通りです。

* EU AI法および関連規制による迅速なコンプライアンス投資(CAGRへの影響:+8.20%): 2024年8月に施行されたEU AI法は、高リスクシステムに対する人間の監視、リスク文書化、アルゴリズムの透明性を義務付けています。最大3,500万ユーロの罰金が課される可能性があるため、説明可能性を標準的な慣行として組み込むガバナンスプログラムへの緊急投資が促されています。この法律の域外適用により、非EUベンダーも製品を適合させる必要があり、北米およびアジア太平洋地域全体でXAI市場が拡大しています。

* モデル中心からデータ中心のAIへの移行と継続的な解釈可能性の要求(CAGRへの影響:+6.80%): 規制当局や実務家は、パフォーマンスの変動が静的なアルゴリズムではなく、変化するデータに起因することが多いと認識しています。2024年に発行されたFDAのガイダンスは、医療機器メーカーに対し、ライフサイクル全体を通じてデータの出所と再トレーニングイベントを追跡することを義務付けています。これにより、企業はすべての推論で説明を生成し、入力の系統をマッピングするプラットフォームを必要としています。

* XAIをデフォルトで組み込むクラウドネイティブなAIガバナンススイート(CAGRへの影響:+5.40%): ハイパースケールプロバイダーは、説明可能性をベースラインサービスに組み込んでいます。IBMのwatsonx.governance、Google CloudのVertex Evaluation Service、AWSのSageMakerの拡張などがその例です。ネイティブな統合により、導入作業が削減され、中堅市場の採用が促進されています。

* 経営層のモデルリスク監視に直面するGenAIパイロットの急増(CAGRへの影響:+4.90%): 生成AIの導入により、説明可能性はデータサイエンスの議題からガバナンスの議題へと移行しました。金融安定理事会(FSB)の2024年11月の評価では、銀行の93%がAIによる利益向上を期待しているものの、制御テストにギャップがあることが指摘されています。経営層の監査委員会は、GenAIプログラムを承認する前に、ヒートマップの可視化、トークンパスの説明、バイアスダッシュボードを要求しています。

* 金融サービスにおけるMRM(モデルリスク管理)義務のXAIへの拡大(CAGRへの影響:+3.10%):

* KubernetesおよびMLOps向けオープンソースライブラリの商用化(CAGRへの影響:+2.60%):

市場の抑制要因

XAI市場の成長を抑制する主な要因は以下の通りです。

* 検証済みのドメイン固有XAIベンチマークの不足(CAGRへの影響:-4.70%): ヘルスケアの臨床医、銀行家、規制当局は、統一された合否基準が存在しないため、説明の品質を比較するのに苦労しています。各実装で独自の指標を作成する必要があり、プロジェクトの期間が延長され、採用が抑制されています。

* モデル内部を公開する際の知的財産開示に関する法的曖昧さ(CAGRへの影響:-3.20%): 企業は、詳細な説明が企業秘密を漏洩する可能性があると懸念しています。2024年に発行された米国特許商標庁(USPTO)のガイダンスは、特許開示と専有保護の間の緊張を浮き彫りにしています。

* 複雑なマルチモーダルアーキテクチャに対する限定的な解釈可能性(CAGRへの影響:-2.40%):

* 主要なテクノロジーハブ以外での専門XAI人材の不足(CAGRへの影響:-1.90%):

セグメント分析

* オファリング別:

ソリューションは2024年に46.8億米ドルの収益を上げ、市場の74%を占めました。これは、企業が特徴の帰属やバイアススキャンを自動化するツールキットをライセンス供与しているため、引き続き拡大しています。MLOpsパイプライン、クラウドコンソール、データカタログとの統合の深さが重要な購入基準となっています。サービスは収益の割合は小さいものの、成長の原動力となっています。規制監査、モデルリスク認証、AIリテラシー向上トレーニングなどが、継続的なコンサルティング収益を生み出しています。

* 展開形態別:

クラウドは2024年の支出の67%を占め、ハイパースケールの弾力性と共有GPUプールの経済性を反映しています。クラウド展開は、進化する規制に対応するための集中型アップデートによって市場シェアを拡大しています。従量課金制の料金体系は、オンプレミスGPUクラスターを正当化できない中堅企業にとって参入障壁を低くしています。オンプレミス導入は、防衛や重要インフラなどのデータ主権環境で依然として存在しています。しかし、特に高度なGPUの半導体不足が拡大を妨げています。

* エンドユーザー産業別:

BFSIは、10年間のモデルリスク規制を背景に、2024年の収益の29%を占めました。ヘルスケアは、FDAの2024年医療機器ガイダンスを受けて、2030年までに年間42.1%の成長が予測される、最も大きな機会を持つ分野です。臨床関係者が診断を患者経路に統合する前にアルゴリズムの明確性を要求するため、ヘルスケアにおけるXAI市場規模は最も急速に拡大するでしょう。製造、小売、IT・通信は、インダストリー5.0やハイパーパーソナライゼーションの取り組みを背景に、10%台半ばのCAGRを記録しています。

地域分析

* 北米: 2024年の売上高の43%を占め、成熟したBFSIおよびヘルスケアのエコシステムがコンプライアンス対応のAIツールを必要としています。連邦準備制度理事会(FRB)のSR 11-7の期待、FDAの透明性義務、および採用を加速させる集中型クラウドインフラストラクチャがこの地域に恩恵をもたらしています。

* アジア太平洋: 2030年までに31.8%のCAGRを記録する最も急速に成長している地域です。日本のAI市場が2024年の45億米ドルから2027年には73億米ドルに拡大すると予測されていることが、国レベルの勢いを示しています。シンガポール金融管理局は責任あるAIツールキットを推進し、中国の生成AIに関する暫定措置はアルゴリズムの透明性を強制しています。

* ヨーロッパ: 北米の規模とアジア太平洋の速度の間に位置しています。EU AI法は、高リスクシステムガバナンスの事実上の世界的基準として欧州連合を位置付けています。ベンダーは、すべてのEU公用語で文書テンプレート、バイアステストモジュール、ユーザーフレンドリーなダッシュボードを提供する必要があります。

競争環境

XAI市場は中程度の断片化を示しています。IBM、Microsoft、Amazon、Googleといった大手企業は、既存の顧客基盤とエコシステムロックインを活用し、XAIを主要なAIサービスに組み込んでいます。彼らの規模の優位性は、R&D、コンプライアンスマッピング、エッジからクラウドへの統合をカバーしており、中堅の競合他社が追いつくのは困難です。これらの大手企業は主にプラットフォームの利用を通じて収益を上げており、バンドルされた採用を通じてXAI市場を拡大しています。

Fiddler AI、Arthur AI、H2O.aiなどの専門企業は、より深い診断、ドメインパック、オープンアーキテクチャコネクタを通じて差別化を図っています。ベンチャー資金が迅速なイテレーションサイクルを支えており、例えばFiddlerは可観測性機能の拡大のために累積5,000万米ドルのシリーズB資金を確保しました。戦略的買収も活発化しており、SnowflakeがTrueraを買収してデータクラウドにXAIを組み込んだり、NvidiaがLepton AIに関心を示したりしています。CapgeminiやPwCのようなグローバルシステムインテグレーターとのパートナーシップは、グローバルな提供ネットワークを持たないツールメーカーのサービス範囲を広げています。

2024年のUSPTOのAIガイダンスを受けて、特許出願の速度が増加しています。大手企業が量で優位に立つ一方で、ニッチなプロバイダーは反事実的説明やマルチモーダル帰属など、アルゴリズム固有のクレームに焦点を当てています。知的財産を巡る競争は、競争の緊急性と方法論を公開から保護する必要性の両方を浮き彫りにしています。全体として、技術的差別化、規制への適合、およびエコシステムパートナーシップが、XAI市場における競争を形成する主要な要素となっています。

主要な業界リーダーには、IBM Corporation、Microsoft Corporation、Amelia US LLC、Google LLC、Arthur.aiなどが挙げられます。

最近の業界動向

* 2025年6月: Fiddler AIがCarahsoftと提携し、米国の公共部門機関全体でAIの可観測性を拡大しました。

* 2025年4月: ArtisanがGlade Brook Capital主導で2,500万米ドルのシリーズAラウンドを完了し、説明可能なセールスエージェントプラットフォームを拡大しました。

* 2025年3月: Nvidiaが数億米ドルでLepton AIを買収する意向を発表し、モデル説明ツールを強化しました。

* 2025年2月: Together AIが3億500万米ドルのシリーズB資金調達を確保し、評価額は33億米ドルに達し、透明性機能を強調しました。

説明可能なAI(XAI)市場に関する本レポートは、機械学習アルゴリズムの出力に対する人間の理解と信頼を可能にするXAIの重要性を強調しています。XAIは、AIモデルの期待される影響、潜在的なバイアス、精度、公平性、透明性を説明し、AIを活用した意思決定における信頼構築と責任あるAI開発に不可欠であると定義されています。

市場規模と成長予測に関して、XAI市場は2025年に63.3億米ドルと評価され、2030年までに183.4億米ドルに達すると予測されています。

市場の成長を牽引する主な要因としては、EU AI法をはじめとするリスクベースの規制によるコンプライアンス支出の急増が挙げられます。この規制は、高リスクシステムに対する透明性を義務付け、最大3,550万ユーロの罰金を科すことで、世界中の企業が市場アクセスを確保するために説明可能性を組み込むよう促しています。また、モデル中心からデータ中心AIへの移行に伴う継続的な解釈可能性の要求、XAIをデフォルトで組み込んだクラウドネイティブなAIガバナンススイートの普及も重要な推進要因です。さらに、取締役会レベルでの「モデルリスク」審査に直面する生成AIパイロットの増加、金融サービスにおけるモデルリスク管理(MRM)義務のXAIへの拡大、KubernetesおよびMLOps向けオープンソース説明可能性ライブラリの商用化も市場拡大に寄与しています。

一方、市場の成長を抑制する要因としては、検証済みのドメイン固有XAIベンチマークの不足、モデル内部を公開する際の知的財産開示に関する法的曖昧さが挙げられます。これらの不確実性は、特に規制の厳しい業界での意思決定を遅らせる傾向にあります。データサイエンスチームによる知覚されるレイテンシーオーバーヘッドへの抵抗や、不透明な生成AIモデルに説明可能性を後付けする際のTCO(総所有コスト)の上昇も課題となっています。

XAI市場は、提供形態(ソリューション、サービス)、展開形態(クラウド、オンプレミス)、エンドユーザー産業(BFSI、ヘルスケア、製造、小売、IT・通信、その他)、および地域(北米、南米、欧州、アジア太平洋、中東・アフリカ)によってセグメント化されています。

展開形態では、クラウド展開が2024年に収益シェアの67%を占め、スケーラブルなGPUアクセスと迅速なコンプライアンス更新により、33.6%のCAGRで市場を牽引しています。エンドユーザー産業では、ヘルスケア分野が最も急速に成長しており、2024年に発行されたFDAガイダンスがAI対応医療機器に継続的な透明性を要求していることから、2030年まで42.1%のCAGRで成長すると予測されています。

競争環境においては、IBM、Microsoft、Google Cloud、AWSといった大手企業がプラットフォーム統合を通じて市場をリードしています。一方、Fiddler AIやArthur AIのような専門企業は、詳細なモデル診断や業界特化型カスタマイズにおいて強みを発揮しています。主要企業には、これら大手および専門企業に加え、NVIDIA Corp、Seldon、H2O.ai、DataRobot、SAS Institute、Alteryx、Ditto.ai、Amelia US LLC、Intel Corp、Mphasis、Accenture、PwC、Atos、Capgeminiなどが挙げられます。

本レポートは、調査の前提と範囲、調査方法、エグゼクティブサマリーから始まり、市場概要、市場の推進要因と抑制要因、産業バリューチェーン分析、規制環境、技術的展望、ポーターのファイブフォース分析、ユースケース分析、ケーススタディ分析といった市場の全体像を詳細に分析しています。また、提供形態、展開形態、エンドユーザー産業、地域別の市場規模と成長予測、競争環境、主要企業のプロファイル、市場機会と将来展望についても網羅的に記述されています。

1. はじめに

- 1.1 調査の前提と市場の定義

- 1.2 調査範囲

2. 調査方法

3. エグゼクティブサマリー

4. 市場概況

- 4.1 市場概要

- 4.2 市場の推進要因

- 4.2.1 EU AI法およびその他のリスクベース規制によって引き起こされる迅速なコンプライアンス支出

- 4.2.2 モデル中心からデータ中心のAIへの移行による継続的な解釈可能性の要求

- 4.2.3 XAIをデフォルトで組み込んだクラウドネイティブなAIガバナンススイート

- 4.2.4 役員レベルの「モデルリスク」精査に直面するGenAIパイロットの急増

- 4.2.5 金融サービスMRM義務(SR 11-7、ECBガイド)がXAIをカバーするように拡大

- 4.2.6 KubernetesおよびMLOps向けに商用化されたオープンソースの解釈可能性ライブラリ

- 4.3 市場の阻害要因

- 4.3.1 検証済みのドメイン固有XAIベンチマークの不足

- 4.3.2 モデル内部を公開する際のIP開示に関する法的曖昧さ

- 4.3.3 知覚されるレイテンシオーバーヘッドによるデータサイエンスチームからの抵抗

- 4.3.4 不透明なGenAIモデルに説明可能性を後付けする際のTCOの増加

- 4.4 産業バリューチェーン分析

- 4.5 規制環境

- 4.6 技術的展望

- 4.7 ポーターの5つの力分析

- 4.7.1 供給者の交渉力

- 4.7.2 買い手の交渉力

- 4.7.3 新規参入の脅威

- 4.7.4 代替品の脅威

- 4.7.5 競争上の対立

- 4.8 ユースケース分析

- 4.9 ケーススタディ分析

5. 市場規模と成長予測(金額)

- 5.1 提供別

- 5.1.1 ソリューション

- 5.1.2 サービス

- 5.2 展開別

- 5.2.1 クラウド

- 5.2.2 オンプレミス

- 5.3 エンドユーザー産業別

- 5.3.1 BFSI

- 5.3.2 ヘルスケア

- 5.3.3 製造業

- 5.3.4 小売

- 5.3.5 ITおよび電気通信

- 5.3.6 その他のエンドユーザー産業

- 5.4 地域別

- 5.4.1 北米

- 5.4.2 南米

- 5.4.3 ヨーロッパ

- 5.4.4 アジア太平洋

- 5.4.5 中東およびアフリカ

6. 競争環境

- 6.1 市場集中度

- 6.2 戦略的動向

- 6.3 市場シェア分析

- 6.4 企業プロファイル(グローバルレベルの概要、市場レベルの概要、主要セグメント、利用可能な財務情報、戦略情報、主要企業の市場ランキング/シェア、製品とサービス、および最近の動向を含む)

- 6.4.1 IBM Corporation

- 6.4.2 Microsoft Corporation

- 6.4.3 Google LLC

- 6.4.4 Amazon Web Services

- 6.4.5 NVIDIA Corp

- 6.4.6 Arthur AI

- 6.4.7 Fiddler AI

- 6.4.8 Seldon

- 6.4.9 H2O.ai

- 6.4.10 DataRobot

- 6.4.11 SAS Institute

- 6.4.12 Alteryx

- 6.4.13 Ditto.ai

- 6.4.14 Amelia US LLC

- 6.4.15 Intel Corp

- 6.4.16 Mphasis

- 6.4.17 Accenture

- 6.4.18 PwC

- 6.4.19 Atos

- 6.4.20 Capgemini

7. 市場機会と将来展望

*** 本調査レポートに関するお問い合わせ ***

説明可能なAI(Explainable AI、XAI)は、人工知能(AI)システムがその意思決定プロセスや予測結果を人間が理解できる形で説明する能力、またはそのための技術や概念を指します。従来のAI、特に深層学習モデルは高い予測精度を誇る一方で、その内部構造が複雑で、なぜ特定の結論に至ったのかが人間には理解しにくい「ブラックボックス」と化していました。説明可能なAIは、このブラックボックス問題を解決し、AIの信頼性、透明性、公平性を高めることを目的としています。単に「何が予測されたか」だけでなく、「なぜそのように予測されたのか」「どの要素がその予測に最も寄与したのか」を明確にすることで、AIの社会受容性を向上させ、より責任あるAIの利用を促進します。

説明可能なAIには、大きく分けて「事前説明型」と「事後説明型」の二つのアプローチがあります。事前説明型(Intrinsic XAIまたはAnte-hoc XAI)は、モデル自体が元々解釈しやすい構造を持つものを指します。例えば、決定木、線形回帰、ロジスティック回帰などがこれに該当します。これらのモデルは、その構造から直接的に予測の根拠を理解できるため、説明と予測が一体となっています。しかし、複雑な問題に対しては、深層学習などのブラックボックスモデルに比べて予測精度が劣る場合があります。一方、事後説明型(Post-hoc XAI)は、複雑なブラックボックスモデルの予測結果を、そのモデルの学習後に外部から分析し、説明を生成する手法です。これはさらに、特定の予測に対する説明を行う「局所的説明」と、モデル全体の振る舞いを説明する「大域的説明」に分けられます。局所的説明の代表的な手法には、LIME(Local Interpretable Model-agnostic Explanations)やSHAP(SHapley Additive exPlanations)があります。LIMEは、特定の入力データ周辺でモデルの振る舞いを線形モデルで近似し、その予測に寄与した特徴量を提示します。SHAPは、ゲーム理論のシャプレー値に基づき、各特徴量が予測にどれだけ貢献したかを公平に配分することで、より厳密な説明を提供します。画像認識分野では、Grad-CAMなどが、特定の予測に寄与した画像領域を可視化します。大域的説明の手法としては、特徴量の重要度分析や、部分依存プロット(Partial Dependence Plot, PDP)、ICEプロット(Individual Conditional Expectation Plot)などがあり、モデル全体の学習したルールや傾向を理解するのに役立ちます。事後説明型は、高精度なブラックボックスモデルの解釈を可能にする一方で、生成される説明の忠実性や安定性が課題となることもあります。

説明可能なAIの用途は多岐にわたります。医療分野では、診断支援AIが提示する病名や治療法の根拠を医師が理解し、患者への説明責任を果たす上で不可欠です。これにより、誤診のリスクを低減し、医療の質を高めることができます。金融分野では、信用スコアリングや不正検知において、融資判断の理由を顧客や規制当局に説明することが求められます。これは、公平性の確保やコンプライアンス遵守の観点から極めて重要です。自動運転技術においては、事故発生時の責任追及や、AIの判断プロセスの検証に説明可能性が不可欠であり、安全性と信頼性の向上に直結します。人事・採用の分野では、AIによる採用判断の公平性を確保し、無意識のバイアスを排除するために説明可能なAIが活用されます。製造業では、異常検知や品質管理において、問題発生時の原因特定を迅速に行うことで、生産効率の向上に貢献します。法執行や司法の分野でも、犯罪予測や再犯リスク評価にAIが利用される際、その判断根拠の透明性は社会の信頼を得る上で不可欠です。また、AIモデルの研究開発においても、説明可能なAIはモデルのデバッグや改善点の特定に役立ちます。

説明可能なAIに関連する技術や概念も多く存在します。公平性AI(Fairness AI)は、AIが特定のグループに対して不当な差別を行わないようにする技術であり、説明可能なAIは、モデル内のバイアスを特定し、その是正に貢献します。プライバシー保護AI(Privacy-preserving AI)は、差分プライバシーや連合学習などの技術を用いて個人情報を保護しながらAIを開発・運用するもので、説明可能なAIと組み合わせることで、プライバシーを保護しつつモデルの透明性を確保できます。因果推論(Causal Inference)は、単なる相関関係だけでなく、事象間の因果関係を特定する技術であり、「なぜ」を説明する説明可能なAIにとって、因果関係の理解はより深い洞察をもたらします。モデル監査(Model Auditing)は、AIモデルの性能、公平性、セキュリティなどを第三者が検証するプロセスであり、説明可能なAIは監査の重要なツールとして機能します。さらに、人間中心AI(Human-Centered AI)は、AIシステムが人間のニーズ、価値観、能力を考慮して設計されるアプローチであり、説明可能なAIは人間とAIの協調を促進し、AIの使いやすさと信頼性を高める上で中心的な役割を担います。

説明可能なAIが注目される背景には、市場における複数の要因があります。まず、規制の強化が挙げられます。EUのGDPR(一般データ保護規則)では、AIによる自動化された意思決定に対して「説明を受ける権利」が明記されており、各国政府やOECDなどもAI倫理ガイドラインを策定し、AIの透明性や説明責任を強く求めています。特に金融分野では、AIの判断に対する説明責任が厳しく問われます。次に、倫理的懸念の高まりがあります。AIによる差別、バイアス、不透明な意思決定は社会的な批判を招きやすく、AIの社会受容性を高めるためには、その判断根拠を明確にすることが不可欠です。最後に、ビジネス上の要請も大きな推進力となっています。説明可能なAIは、AIの信頼性を向上させ、企業がAIをより安心して導入・活用できるようにします。また、モデルのデバッグや改善プロセスを効率化し、リスク管理やコンプライアンス対応を強化することで、企業の競争優位性の確保にも寄与します。

将来の展望として、説明可能なAIはさらなる技術的進化と社会実装の深化が期待されています。技術面では、より忠実で安定した説明手法の開発が進むでしょう。画像、テキスト、音声など複数のモダリティを扱うマルチモーダルAIに対する説明手法や、リアルタイムでの説明生成技術の進化が期待されます。また、人間がより直感的に理解できる自然言語による説明や、インタラクティブな視覚化ツールの開発も進むでしょう。社会実装の面では、説明の品質や信頼性を評価する標準化された指標の確立、および業界ごとのガイドラインやベストプラクティスの策定が重要となります。説明可能なAIは、人間の専門知識と融合し、より高度な意思決定を支援するツールとしての役割を強化していくと考えられます。AI教育においても、説明可能性の重要性が増し、AI開発者や利用者がその概念を深く理解することが求められるでしょう。一方で、説明の正確性と簡潔性のトレードオフ、説明の悪用(不当な判断を正当化するために説明を操作するリスク)、計算コストの増大、そして説明の対象となるユーザー層に応じたカスタマイズの難しさなど、依然として多くの課題が残されています。これらの課題を克服し、説明可能なAIが社会に広く浸透することで、AIはより信頼され、責任ある形で私たちの生活やビジネスに貢献していくことでしょう。