ニューラルプロセッサ市場規模・シェア分析 – 成長トレンドと予測 (2025年~2030年)

ニューラルプロセッサー市場レポートは、製品タイプ(エッジNPU、データセンターNPU、コプロセッサーおよびアクセラレーターなど)、アーキテクチャ(ASICベース、GPUベースなど)、エンドユース産業(家電、自動車、ヘルスケアなど)、展開モード(オンプレミス/エッジ、クラウド)、および地域(北米、南米、欧州など)によって分類されます。市場予測は、金額(米ドル)で提供されます。

※本ページの内容は、英文レポートの概要および目次を日本語に自動翻訳したものです。最終レポートの内容と異なる場合があります。英文レポートの詳細および購入方法につきましては、お問い合わせください。

*** 本調査レポートに関するお問い合わせ ***

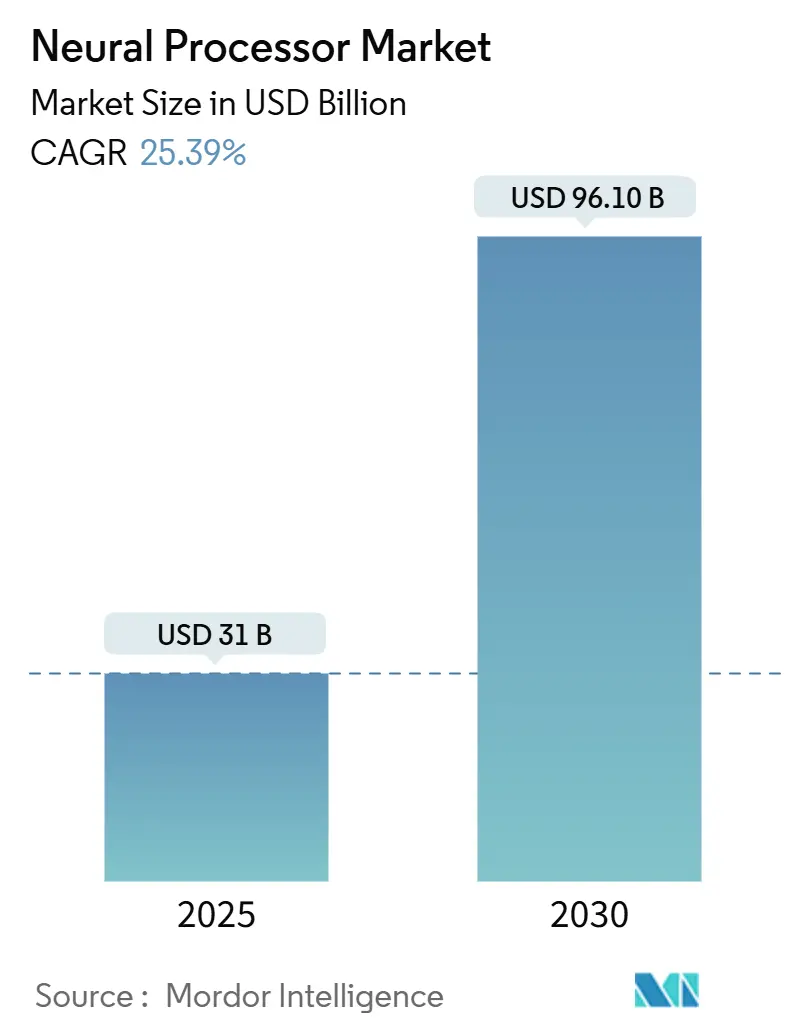

ニューラルプロセッサー市場は、2025年の310億米ドルから2030年には961億米ドルへと大幅な成長が見込まれており、予測期間中の年平均成長率(CAGR)は25.39%に達すると予測されています。この成長は、ハイパースケールデータセンターにおけるAI推論ワークロードの効率的な管理需要と、各国政府による自国チップ開発イニシアチブが主な要因です。市場規模は2025年に310億米ドル、2030年には961億米ドルに達し、CAGRは25.39%です。最も成長の速い市場はアジア太平洋地域、最大の市場は北米であり、市場集中度は中程度です。主要プレイヤーにはNvidia Corporation、Intel Corporation、Cerebras Systems Inc.、Graphcore Ltd.、Qualcomm Technologies, Inc.などが挙げられます。

主要なレポートのポイント

* 製品タイプ別: エッジNPUは29.4%のCAGRで最速成長し、データセンターNPUは2024年に51.6%の市場シェアを維持しました。

* アーキテクチャ別: GPUは2024年に41.7%の収益を占めましたが、ASICベースのNPUは2030年までに26.7%のCAGRでGPUを上回ると予測されています。

*アプリケーション別: 自然言語処理は2024年に最大の市場シェアを占め、自動運転は最も高い成長率を示すと予想されています。

ニューラルプロセッサ市場に関する本レポートは、市場の現状、成長予測、主要な推進要因と阻害要因、および競争環境を詳細に分析しています。

市場概要と成長予測

2025年には310億米ドルと評価されるこの市場は、2030年までに961億米ドルに達すると予測されており、25.39%という堅調な年平均成長率(CAGR)で拡大する見込みです。この成長は、クラウドおよびエッジコンピューティングの両方におけるAIワークロードの増加によって強力に牽引されています。

市場の推進要因

市場の成長を加速させる主な要因としては、データセンターにおけるAIワークロードの加速、コンシューマーデバイスにおけるエッジAIの普及、自動車の先進運転支援システム(ADAS)および自動運転技術の採用拡大が挙げられます。さらに、エネルギー効率の高いAIアクセラレーションへの需要の高まり、NPU向けオープンソースAIフレームワークの最適化、そして各国政府による半導体自給自足プログラムも市場拡大に寄与しています。

市場の阻害要因

一方で、市場の成長を抑制する要因も存在します。先進ノードに対する地政学的な輸出規制は潜在的なCAGRを3.8%減少させ、高額な初期設計およびテープアウトコストは2.9%の減少要因となっています。また、ニューロモーフィックアーキテクチャ設計における人材不足や、ソフトウェアツールチェーンの断片化も課題として挙げられています。

市場セグメンテーション

* 製品タイプ別: エッジニューラルプロセッシングユニット(NPU)、データセンターNPU、コプロセッサおよびアクセラレータ、ビジョンプロセッサ、AIシステムオンチップ(SoC)などが分析対象となっています。

* アーキテクチャ別: ASICベースNPU、GPUベースNPU、FPGAベースNPU、ハイブリッド/チップレットアーキテクチャが調査されています。現在、GPUが収益シェアの41.7%を占めていますが、ワークロードに特化した効率性の向上により、ASICベースNPUは26.7%のCAGRで急速に成長し、その差を縮めています。

* 最終用途産業別: エンタープライズITおよびクラウドアプリケーションが2024年に43.8%の収益シェアを占め、最も支配的なセグメントであり、28.1%という最も強力なCAGRを維持すると予測されています。その他、コンシューマーエレクトロニクス、自動車および輸送、ヘルスケアおよびライフサイエンス、産業および製造業も重要なセグメントです。

* 展開モード別: オンプレミス/エッジとクラウドに分類され、それぞれの市場動向が分析されています。

* 地域別: アジア太平洋地域が30.07%のCAGRで最も急速に成長している地域であり、各国のチップ産業振興策や強力なエレクトロニクス製造基盤がその背景にあります。北米、南米、ヨーロッパ、中東およびアフリカも詳細に分析されています。

競争環境

競争環境の分析では、市場集中度、戦略的動向、市場シェア分析が行われています。Nvidia Corporation、Intel Corporation、Advanced Micro Devices, Inc.、Qualcomm Technologies, Inc.、Arm Ltd.など、主要な企業プロファイルが提供されており、各社のグローバルおよび市場レベルの概要、主要セグメント、財務情報、戦略、市場ランク/シェア、製品とサービス、最近の動向が含まれています。

市場機会と将来展望

レポートでは、市場機会と将来展望についても言及されており、未開拓の分野や満たされていないニーズの評価が含まれています。

1. はじめに

- 1.1 調査の前提条件と市場の定義

- 1.2 調査範囲

2. 調査方法

3. エグゼクティブサマリー

4. 市場概況

- 4.1 市場概要

-

4.2 市場の推進要因

- 4.2.1 データセンターにおけるAIワークロードの加速

- 4.2.2 消費者デバイスにおけるエッジAIの普及

- 4.2.3 自動車ADASおよび自動運転の採用

- 4.2.4 エネルギー効率の高いAIアクセラレーションへの需要の高まり

- 4.2.5 NPU向けオープンソースAIフレームワークの最適化

- 4.2.6 国家半導体自給自足プログラム

-

4.3 市場の阻害要因

- 4.3.1 先端ノードに対する地政学的輸出規制

- 4.3.2 高額な初期設計およびテープアウト費用

- 4.3.3 ニューロモーフィックアーキテクチャ設計における人材不足

- 4.3.4 ソフトウェアツールチェーンの断片化

- 4.4 産業バリューチェーン分析

- 4.5 規制環境

- 4.6 技術的展望

- 4.7 マクロ経済要因の影響

-

4.8 ポーターの5つの力分析

- 4.8.1 新規参入者の脅威

- 4.8.2 買い手の交渉力

- 4.8.3 供給者の交渉力

- 4.8.4 代替品の脅威

- 4.8.5 競争の激しさ

5. 市場規模と成長予測(金額)

-

5.1 製品タイプ別

- 5.1.1 エッジニューラルプロセッシングユニット(NPU)

- 5.1.2 データセンターNPU

- 5.1.3 コプロセッサーおよびアクセラレーター

- 5.1.4 ビジョンプロセッサー

- 5.1.5 AIシステムオンチップ(SoC)

-

5.2 アーキテクチャ別

- 5.2.1 ASICベースNPU

- 5.2.2 GPUベースNPU

- 5.2.3 FPGAベースNPU

- 5.2.4 ハイブリッド / チップレットアーキテクチャ

-

5.3 最終用途産業別

- 5.3.1 家庭用電化製品

- 5.3.2 自動車および輸送

- 5.3.3 ヘルスケアおよびライフサイエンス

- 5.3.4 産業および製造

- 5.3.5 エンタープライズITおよびクラウド

-

5.4 展開モード別

- 5.4.1 オンプレミス / エッジ

- 5.4.2 クラウド

-

5.5 地域別

- 5.5.1 北米

- 5.5.1.1 米国

- 5.5.1.2 カナダ

- 5.5.1.3 メキシコ

- 5.5.2 南米

- 5.5.2.1 ブラジル

- 5.5.2.2 アルゼンチン

- 5.5.2.3 その他の南米諸国

- 5.5.3 ヨーロッパ

- 5.5.3.1 ドイツ

- 5.5.3.2 イギリス

- 5.5.3.3 フランス

- 5.5.3.4 イタリア

- 5.5.3.5 スペイン

- 5.5.3.6 ロシア

- 5.5.3.7 その他のヨーロッパ諸国

- 5.5.4 アジア太平洋

- 5.5.4.1 中国

- 5.5.4.2 日本

- 5.5.4.3 インド

- 5.5.4.4 韓国

- 5.5.4.5 東南アジア

- 5.5.4.6 その他のアジア太平洋諸国

- 5.5.5 中東およびアフリカ

- 5.5.5.1 中東

- 5.5.5.1.1 サウジアラビア

- 5.5.5.1.2 アラブ首長国連邦

- 5.5.5.1.3 その他の中東諸国

- 5.5.5.2 アフリカ

- 5.5.5.2.1 南アフリカ

- 5.5.5.2.2 エジプト

- 5.5.5.2.3 その他のアフリカ諸国

6. 競合情勢

- 6.1 市場集中度

- 6.2 戦略的動向

- 6.3 市場シェア分析

-

6.4 企業プロファイル(グローバルレベルの概要、市場レベルの概要、主要セグメント、利用可能な財務情報、戦略情報、主要企業の市場ランク/シェア、製品とサービス、および最近の動向を含む)

- 6.4.1 Nvidia Corporation

- 6.4.2 Intel Corporation

- 6.4.3 Cerebras Systems Inc.

- 6.4.4 Graphcore Ltd.

- 6.4.5 Advanced Micro Devices, Inc.

- 6.4.6 Tenstorrent Inc.

- 6.4.7 Mythic AI, Inc.

- 6.4.8 SambaNova Systems, Inc.

- 6.4.9 Qualcomm Technologies, Inc.

- 6.4.10 Arm Ltd.

- 6.4.11 Blaize, Inc.

- 6.4.12 Hailo Technologies Ltd.

- 6.4.13 Eta Compute, Inc.

- 6.4.14 GreenWaves Technologies

- 6.4.15 Syntiant Corp.

- 6.4.16 Esperanto Technologies, Inc.

- 6.4.17 Flex Logix Technologies, Inc.

- 6.4.18 BrainChip Holdings Ltd.

- 6.4.19 FuriosaAI

- 6.4.20 Lightmatter, Inc.

- 6.4.21 Untether AI Corp.

- 6.4.22 Gyrfalcon Technology Inc.

- 6.4.23 Neuchips Corp.

- 6.4.24 TetraMem Inc.

- 6.4.25 Edge Impulse, Inc.

7. 市場機会と将来展望

*** 本調査レポートに関するお問い合わせ ***

ニューラルプロセッサとは、人工知能(AI)の処理、特にディープラーニング(深層学習)における計算を効率的かつ高速に実行するために特化して設計された半導体チップのことです。NPU(Neural Processing Unit)とも呼ばれ、人間の脳の神経回路網を模倣したアーキテクチャを特徴としています。従来のCPU(中央演算処理装置)やGPU(画像処理装置)が汎用的な計算やグラフィック処理に優れるのに対し、ニューラルプロセッサはAIモデルの学習や推論に必要な行列演算や畳み込み演算といった特定の計算を、並列処理によって低消費電力で高速に実行することに特化しています。これにより、AIアプリケーションの性能を飛躍的に向上させることが可能になります。

ニューラルプロセッサには、その用途や規模に応じていくつかの種類が存在します。一つは、スマートフォンやPC、タブレットなどのコンシューマーデバイスに搭載される「汎用NPU」です。これらは、デバイス上でのリアルタイムなAI処理(例:画像認識、音声認識、自然言語処理)を低消費電力で実現するために設計されています。AppleのNeural EngineやQualcommのAI Engine、IntelのMovidius VPUなどがその代表例です。次に、データセンターやクラウド環境で大規模なAIモデルの学習や推論を行うための「データセンター向けNPU/AIアクセラレータ」があります。これらは膨大な計算能力を要求されるため、NVIDIAのTensor Coreを搭載したGPUや、Googleが開発したTPU(Tensor Processing Unit)のように、特定のAI演算に特化した強力なハードウェアが用いられます。さらに、IoTデバイス、車載システム、産業用ロボットなど、特定の組み込み用途に特化した「組み込みNPU」も存在します。これらは、限られた電力とリソースの中で、リアルタイム性と信頼性を重視したAI処理を実現します。研究段階ではありますが、アナログ信号処理を利用した「アナログNPU」や、光の特性を利用した「光NPU」なども、将来的な超低消費電力・高速化を目指して開発が進められています。

ニューラルプロセッサの用途は非常に広範にわたります。最も身近な例としては、スマートフォンにおける顔認証、音声アシスタント、カメラのシーン認識やポートレートモードの強化、AR(拡張現実)アプリケーションなどが挙げられます。PCでは、ビデオ会議での背景ぼかしやノイズ除去、画像・動画編集の高速化などに活用されています。データセンターやクラウド環境では、検索エンジンの精度向上、レコメンデーションシステムの最適化、大規模な自然言語処理モデル(例:GPTシリーズ)の学習と推論、医療画像診断支援、金融分野での不正検知や市場予測など、多岐にわたるAIサービスを支えています。自動運転技術においては、車両に搭載されたセンサー(カメラ、LiDAR、レーダーなど)から得られる膨大なデータをリアルタイムで処理し、物体検出、経路計画、運転判断を行う上でニューラルプロセッサが不可欠です。また、スマート家電、監視カメラ、産業用ロボットなどのIoT・エッジデバイスでは、クラウドにデータを送ることなくデバイス上でAI処理を行う「エッジAI」を実現し、プライバシー保護、低遅延、通信コスト削減に貢献しています。

関連技術としては、まずディープラーニングのモデル開発に用いられる「ディープラーニングフレームワーク」(TensorFlow、PyTorchなど)が挙げられます。ニューラルプロセッサは、これらのフレームワークで開発されたモデルを効率的に実行するためのハードウェア基盤です。また、NPUの性能を最大限に引き出すためには、AIモデルの「最適化技術」(量子化、プルーニング、蒸留など)が重要になります。これにより、モデルのサイズを縮小し、計算量を削減することで、NPU上での実行効率を高めます。さらに、NPUのハードウェア特性を活かすための「コンパイラ」や「ソフトウェア開発キット(SDK)」も不可欠です。半導体製造技術の進化(微細化、3D積層技術など)も、NPUの性能向上に直結しています。クラウドコンピューティングは、大規模なAI学習環境を提供し、エッジコンピューティングはNPUがエッジデバイスでの自律的なAI処理を可能にする重要な概念です。

市場背景としては、AI技術の急速な進化と社会実装の加速が、ニューラルプロセッサ市場を強力に牽引しています。ビッグデータの爆発的な増加に伴い、これらのデータを効率的に処理し、価値ある情報に変換する必要性が高まっています。特に、モバイルデバイスやエッジデバイスでのAI利用が増えるにつれて、低消費電力でリアルタイムなAI処理が求められるようになり、ニューラルプロセッサの重要性が一層増しています。自動運転や産業用ロボットといった分野では、ミリ秒単位のリアルタイム処理が安全や生産性に直結するため、NPUの需要は今後も拡大する見込みです。現在、NVIDIA、Google、Apple、Qualcomm、Intel、Huaweiといった半導体メーカーやIT巨人が、高性能なニューラルプロセッサの開発競争を繰り広げており、市場規模は今後も高い成長が見込まれています。

将来展望としては、ニューラルプロセッサはさらなる性能向上と多様化が進むでしょう。より高速で低消費電力、高精度なNPUの開発が進むとともに、特定の用途に特化したカスタムNPUの増加が予想されます。ハードウェアとソフトウェアの連携も一層強化され、AI開発者がNPUの性能を容易に引き出せるような開発環境が整備されていくでしょう。また、アナログコンピューティングや光コンピューティング、さらには量子コンピューティングといった新たな計算パラダイムとの融合も研究されており、これらが将来の超高性能・超低消費電力なニューラルプロセッサの実現に寄与する可能性があります。エッジAIのさらなる普及は、NPUの進化によって加速され、より多くのデバイスが自律的に高度なAI処理を実行できるようになるでしょう。一方で、AIの公平性、プライバシー保護、セキュリティといった倫理的・社会的な課題への対応も、NPUの設計や利用において重要な考慮事項となっていきます。最終的には、ニューラルプロセッサの進化が、より複雑で高度なAIモデルの実行を可能にし、汎用人工知能(AGI)の実現に向けた重要な一歩となることが期待されています。